De acuerdo con el estudio “Tendencias de HR 2025″ de la empresa Buk, realizado en Colombia, Chile, Perú y México, un 75% de las empresas reportan serias dificultades para encontrar personal calificado, utilizando en varias ocasiones sistemas de inteligencia artificial para optimizar estos procesos, pero no necesariamente los realizan de forma equitativa.

La integración de la IA en estos procesos está generando nuevas preocupaciones, por su potencial para amplificar sesgos y prejuicios preexistentes en lugar de mitigarlos. Casos conocidos, como el del sistema de selección de Amazon en 2017, evidenciaron cómo la IA puede replicar patrones de discriminación de género al priorizar candidatos masculinos.

Este fenómeno no es aislado; una investigación de la Universidad de Cambridge, titulada: ¿La IA elimina el sesgo en el reclutamiento?, concluye que estas tecnologías, en lugar de fomentar la diversidad, pueden aumentar la homogeneidad al buscar “candidatos ideales” basados en perfiles históricamente sesgados.

Cómo se manifiestan los sesgos de la IA en procesos de selección

Los hallazgos del estudio destacan múltiples formas en que estos sistemas perpetúan desigualdades, desde sesgos algorítmicos hasta una subrepresentación en los datos analizados.

En primer lugar, los sistemas de inteligencia artificial se entrenan con datos históricos, lo que puede llevar a la replicación de desigualdades pasadas. Si los datos de entrenamiento priorizan candidatos masculinos para roles de liderazgo, este sesgo se incorporará en las futuras sugerencias del sistema.

Además, el sesgo algorítmico surge cuando los desarrolladores no consideran adecuadamente la diversidad en los algoritmos, lo que puede resultar en exclusiones injustas.

Un tercer tipo de sesgo, relacionado con la subrepresentación en los datos, afecta a minorías raciales y a mujeres, quienes tienen menor probabilidad de ser seleccionados por la falta de información en el sistema.

Qué implica que la IA siga perpetuando la discriminación en las empresas

Estos sesgos no solo afectan la justicia y la inclusión en los procesos de contratación, sino también tienen un impacto directo en las empresas. La falta de diversidad en la fuerza laboral puede limitar la creatividad y la innovación, aspectos cruciales para competir en mercados globales.

Además, las organizaciones podrían enfrentar sanciones legales o pérdidas de reputación corporativa, si se demuestra que sus sistemas de IA perpetúan discriminación.

El estudio de la Universidad de Cambridge subraya que la IA, al buscar candidatos que se ajusten al “perfil ideal”, tiende a reducir la diversidad en lugar de ampliarla. Esto genera equipos de trabajo menos representativos y menos capaces de entender las necesidades de una sociedad plural.

Cuáles son otras preocupaciones de la IA con el uso de la IA

El estudio identifica varias inquietudes entre las organizaciones sobre la aplicación de la inteligencia artificial en recursos humanos. Entre las principales se encuentran la falta de experiencia en el manejo de estas herramientas (57%), dudas relacionadas con la privacidad y la seguridad (49%), la calidad y disponibilidad de los datos (46%), e inquietudes sobre los sesgos de la IA.

Estas preocupaciones reflejan la necesidad de un enfoque más estratégico y cuidadoso en la implementación de sistemas de IA. Sin un control adecuado, las empresas corren el riesgo de perpetuar desigualdades y tomar decisiones poco éticas que afecten su sostenibilidad a largo plazo.

Cómo pueden las empresas mitigar estos problemas de los sistemas de IA

Una de las claves principales del estudio es garantizar que los equipos responsables del diseño y la gestión de sistemas de IA estén capacitados en la identificación y mitigación de sesgos. Estas herramientas deben contar con una visión diversa y que no corresponda a un patrón específico.

Esto incluye involucrar a los departamentos de recursos humanos en el proceso de desarrollo de estas herramientas, fomentando la colaboración con los equipos tecnológicos.

Asimismo, se debe priorizar la recolección de datos representativos y diversos para el entrenamiento de los algoritmos, asegurando que todos los grupos demográficos tengan una participación equitativa. La formación continua de los equipos y la adopción de prácticas éticas en el uso de IA son esenciales para minimizar el riesgo de decisiones injustas.

ultimas

El desafío de las celebridades frente a los deepfakes impulsados por inteligencia artificial

La IA amenaza la privacidad de famosos, quienes ahora buscan herramientas legales para combatir la manipulación de sus imágenes y voces. Rolling Stone analizó el fenómeno

Glosario de tecnología: para qué sirve ‘descomprimir’

La tecnología también ha impactado la salud con dispositivos novedosos y aplicaciones que ayudan a las personas enfermas

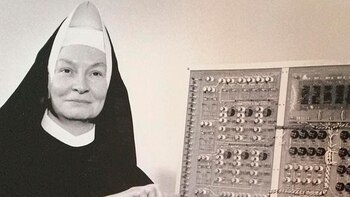

Mary Kenneth Keller, la monja que transformó la informática y rompió barreras en la ciencia y la religión

A través de su visión única, demostró que la fe y la tecnología pueden coexistir, siendo pionera en la programación informática y la primera mujer en obtener un doctorado en esta disciplina, según destaca National Geographic

Así puedes borrar todos los mensajes con virus en el computador: cómo hacerlo en Google Chrome

Estas alertas son engaños para descargar programas maliciosos que monitorean cualquier movimiento y roban información sensible

Netflix por fin añade una función que todos esperaban: descarga temporadas enteras en segundos

La nueva herramienta de la aplicación móvil evita que los usuarios descarguen capítulo por capítulo de forma manual