Transformar un prototipo de agente de inteligencia artificial en un sistema robusto y confiable para producción de IA representa uno de los mayores retos actuales en la adopción empresarial de esta tecnología.

Google ha dado un paso relevante en este campo con la publicación, en noviembre de 2025, de una guía técnica que detalla el ciclo de vida operativo de los agentes de IA, enfocándose en cómo implementarlos, escalarlos y llevarlos a producción de manera segura y eficiente.

El documento, elaborado por Sokratis Kartakis, Gabriela Hernández Larios, Ran Li, Elia Secchi y Huang Xia, ofrece un recorrido exhaustivo por los desafíos y mejores prácticas para que empresas y desarrolladores puedan confiar en estos sistemas más allá de la fase experimental.

La guía de Google parte de una premisa contundente: “Construir un agente es fácil. Confiar en él es difícil”. Si bien crear un prototipo funcional puede tomar minutos, convertirlo en una solución de la que dependa un negocio exige mucho más que inteligencia algorítmica.

Según la experiencia de Google, cerca del 80% del esfuerzo necesario para llevar un agente a producción se destina a la infraestructura, la seguridad y la validación, no al desarrollo del modelo en sí. Saltarse estos pasos puede derivar en fallos críticos, como agentes que entregan productos sin autorización, exponen datos confidenciales o generan costos inesperados por falta de monitoreo.

La guía enfatiza que la clave para superar estos obstáculos radica en tres pilares: evaluación automatizada, despliegue continuo (CI/CD) y observabilidad integral. Estos elementos, combinados, permiten construir la confianza necesaria para operar agentes de IA en entornos reales, donde la autonomía, la gestión de estado y la imprevisibilidad de los caminos de ejecución requieren estrategias especializadas.

Uno de los aspectos centrales que destaca Google es la importancia de los equipos multidisciplinarios y los procesos bien definidos. La tecnología, por sí sola, resulta insuficiente sin el respaldo de especialistas que diseñen, gestionen y supervisen cada etapa.

En este sentido, la guía describe la colaboración entre equipos de arquitectura cloud, ingeniería de datos, ciencia de datos, MLOps, gobernanza y roles emergentes como los ingenieros de prompts.

En organizaciones pequeñas, una misma persona puede asumir varias funciones, mientras que en empresas maduras, la especialización y la coordinación se vuelven esenciales para garantizar la seguridad y la calidad de los agentes.

Para facilitar la adopción de estas prácticas, Google pone como ejemplo su Agent Starter Pack, un paquete de herramientas y plantillas listas para desplegar agentes generativos en Google Cloud, con integración de CI/CD, evaluación automatizada y observabilidad incorporada. Este enfoque práctico permite a los equipos implementar rápidamente los conceptos expuestos en la guía.

El proceso de llevar un agente a producción, según Google, debe estar regido por el principio de “despliegue condicionado por evaluación”. Ninguna versión de un agente debe llegar a los usuarios sin superar una evaluación exhaustiva que demuestre su calidad y seguridad.

Esta evaluación puede realizarse de forma manual, con revisiones entre pares y reportes de desempeño, o de manera automatizada, integrando el proceso en la propia tubería de CI/CD. En ambos casos, el objetivo es bloquear cualquier despliegue que no cumpla con los estándares definidos, utilizando métricas como la tasa de éxito en el uso de herramientas o la utilidad de las respuestas.

El pipeline de CI/CD recomendado por Google se estructura en tres fases. La primera, de integración continua, ejecuta pruebas rápidas y evaluaciones de calidad antes de fusionar cambios en la rama principal del código.

La segunda, de validación en staging, replica el entorno de producción para llevar a cabo pruebas más exhaustivas, incluyendo tests de carga e integración, así como pruebas internas con usuarios de la organización. La tercera fase, el despliegue a producción, requiere la aprobación final de un responsable de producto y promueve el artefacto validado al entorno real, siempre con mecanismos de seguridad y control.

La automatización de este flujo depende de tecnologías como la infraestructura como código (IaC), que garantiza entornos reproducibles y controlados, y marcos de pruebas automatizadas que validan tanto el código como los artefactos específicos de los agentes, como historiales de conversación y trazas de razonamiento. La gestión segura de secretos, como claves de API, también se integra en este proceso para evitar vulnerabilidades.

A pesar de todas las validaciones previas, Google advierte que el entorno real siempre puede revelar problemas imprevistos. Por ello, la guía recomienda estrategias de despliegue seguro, como los rollouts graduales (canary), entornos blue-green, pruebas A/B y el uso de feature flags. Todas estas técnicas se apoyan en un riguroso versionado de cada componente, lo que permite revertir rápidamente a un estado seguro en caso de incidentes.

La seguridad en IA, según Google, debe integrarse desde el diseño del agente. Los riesgos asociados a la autonomía de estos sistemas —como la inyección de prompts maliciosos, la fuga de datos o la corrupción de memoria— requieren una gobernanza sólida desde el primer día.

El enfoque de Google se basa en tres capas: definición de políticas y constitución del agente, implementación de guardrails y filtros tanto en la entrada como en la salida, y pruebas continuas de seguridad.

Herramientas como la API Perspective y los filtros de seguridad de Vertex AI permiten bloquear contenidos dañinos o información sensible antes de que lleguen al usuario. Además, para acciones de alto riesgo, el sistema debe escalar la decisión a un humano.

Una vez en producción, la operación de los agentes de IA demanda un ciclo continuo de observación, acción y evolución. La observabilidad, que incluye logs, trazas y métricas, proporciona la visión necesaria para entender el comportamiento del agente y detectar anomalías.

Google Cloud ofrece soluciones integradas para este propósito, como Cloud Trace, Cloud Logging y Cloud Monitoring, que permiten rastrear cada interacción y recibir alertas ante desviaciones en el rendimiento.

La fase de acción implica intervenir en tiempo real para mantener la estabilidad, el rendimiento y la seguridad del sistema. Esto puede incluir desde el escalado horizontal de servicios sin estado, la gestión asíncrona de tareas complejas, hasta la aplicación de mecanismos de retry ante fallos temporales.

La gestión de costos y la fiabilidad se equilibran mediante el uso de modelos eficientes, cachés y herramientas idempotentes.

En cuanto a la gestión de riesgos, Google recomienda contar con un playbook de respuesta ante incidentes, que incluya la contención inmediata mediante circuit breakers, la revisión humana de solicitudes sospechosas y la implementación de parches a través del pipeline automatizado. Este enfoque permite resolver vulnerabilidades de forma ágil y controlada.

La evolución del agente se basa en aprender de los datos de producción. Cada incidente, fallo o patrón detectado se transforma en un nuevo caso de prueba para la evaluación, refinando prompts, añadiendo herramientas o ajustando guardrails.

El ciclo de mejora continua se cierra gracias a la automatización del pipeline, que permite desplegar cambios en cuestión de horas o días, en lugar de semanas o meses.

En materia de seguridad, este ciclo de retroalimentación se vuelve aún más relevante. Cada nuevo vector de ataque detectado en producción se incorpora como un test permanente, y las defensas se refuerzan de manera proactiva.

Así, la postura de seguridad evoluciona de una actitud defensiva a una mejora continua y anticipada.

Más allá de la operación de agentes individuales, Google subraya la importancia de la interoperabilidad y la colaboración entre agentes para escalar el valor en grandes organizaciones.

La guía introduce dos protocolos clave: el Model Context Protocol (MCP), que estandariza la integración de herramientas y recursos, y el Agent2Agent (A2A), diseñado para permitir la colaboración autónoma y compleja entre agentes desarrollados en diferentes equipos, marcos o nubes. Mientras MCP facilita tareas simples y bien definidas, A2A permite delegar objetivos complejos a agentes especializados, rompiendo los silos organizacionales.

El protocolo A2A se apoya en “Agent Cards”, especificaciones estandarizadas que describen las capacidades, requisitos de seguridad y modos de interacción de cada agente, permitiendo su descubrimiento y consumo dinámico por parte de otros agentes.

Herramientas como el Agent Development Kit (ADK) de Google simplifican la compatibilidad con A2A, permitiendo exponer y consumir agentes con funciones predefinidas. Esta arquitectura habilita composiciones jerárquicas, donde un agente orquestador puede delegar tareas a subagentes locales o remotos, incrementando la eficiencia y la reutilización.

La colaboración entre agentes, sin embargo, exige requisitos técnicos como el trazado distribuido y la gestión robusta del estado, para mantener la coherencia y la auditabilidad de las interacciones. Google recomienda que los nuevos agentes se diseñen con soporte nativo tanto para MCP como para A2A, asegurando su descubribilidad y reutilización desde el inicio.

La guía de Google ofrece un marco integral para llevar agentes de inteligencia artificial desde el laboratorio hasta la operación empresarial, combinando automatización, seguridad, observabilidad y colaboración.

Cada incidente en producción se convierte en una oportunidad de aprendizaje, fortaleciendo al agente y permitiendo que la seguridad y la eficiencia evolucionen de forma proactiva y sostenida.

Últimas Noticias

Khaby Lame vende los derechos de su imagen a la IA para crear gemelos digitales

El creador de contenido vendió su empresa por 975 millones de dólares y ahora habrá videos con su rostro generados con IA

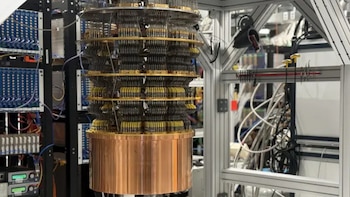

Así es la supercomputadora cuántica de Google que resuelve en minutos lo imposible para la informática clásica

La máquina opera bajo condiciones de frío extremo y resolvió un reto científico que a una supercomputadora tradicional le habría tomado más que la edad del universo

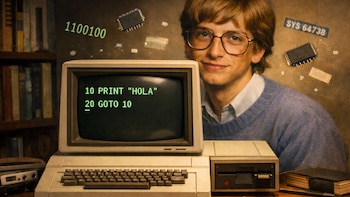

Ya puedes descargar el código fuente de Microsoft BASIC, el software que lanzó a la historia a Bill Gates

La decisión de liberar el software original de BASIC invita a programadores y curiosos a explorar los cimientos de la computación y entender el impacto de la visión de Bill Gates y Paul Allen en la informática

Cómo invertir en criptomonedas paso a paso y cuál es su precio este día

El bitcoin, una de las principales criptomonedas, registra un precio de 75.851,51 dólares