La inteligencia artificial avanza a pasos acelerados en la vida cotidiana, facilitando actividades laborales, educativas o personales. Sin embargo, el crecimiento de estos sistemas, representados en herramientas como Gemini, ChatGPT y otros asistentes, exige comprender sus límites y las razones que fundamentan restricciones.

Detrás de la amabilidad conversacional y la respuesta rápida, existen reglas claras fijadas por motivos éticos, legales y de seguridad. Conocerlas puede evitar frustraciones, problemas legales y malentendidos sobre lo que puede o no resolver una IA.

1. Datos personales tuyos o de terceros

Uno de los pilares de los desarrollos en inteligencia artificial es el respeto a la privacidad de los datos. Tanto Gemini como ChatGPT no ofrecen información personal propia ni de terceros bajo ninguna circunstancia.

Nunca proporcionarán direcciones, números de teléfono, datos bancarios o detalles de documentos personales. Estas políticas buscan evitar el uso indebido de datos sensibles y proteger la identidad de los usuarios frente a potenciales fraudes o robo de información.

Las bases de datos de estos sistemas no incluyen acceso a tales registros, estén o no disponibles públicamente en Internet.

2. Acceso a cuentas o comunicaciones privadas

Solicitar acceso a correos electrónicos, redes sociales o conversaciones privadas está completamente fuera de los límites de la IA. Las plataformas rechazarán de inmediato cualquier intento de obtener contraseñas, mensajes o información de cuentas ajenas.

Intentar vulnerar este principio no solo implica una violación ética, también un acto ilegal con consecuencias legales. Los desarrolladores refuerzan estos límites implementando barreras técnicas estrictas.

3. Solicitar contenido ofensivo o discriminatorio

Otra línea infranqueable para la IA es la generación de contenido ofensivo, discriminatorio o que incite al odio. Tampoco ofrecerán respuestas que refuercen estereotipos, ni producirán material con componentes racistas, violentos o sexualmente inapropiados.

Así, buscan mantener entornos seguros y proteger tanto a los usuarios como a la sociedad en general. La tecnología de moderación opera en tiempo real, anulando cualquier potencial vulneración.

4. Información para realizar actividades ilegales

Desde la fabricación de sustancias ilícitas hasta la piratería informática, la inteligencia artificial mantiene bloqueada cualquier solicitud relacionada con acciones ilegales. No entregará información sobre cómo hackear sistemas, acceder a contenido restringido, fabricar armas caseras o vulnerar leyes en cualquier país.

El objetivo es evitar que la IA sea un canal para difundir conductas o conocimientos peligrosos que puedan afectar a individuos, empresas o gobiernos.

5. Consejos financieros o diagnósticos médicos

Chatbots como ChatGPT o Gemini tampoco están programados para brindar consejos financieros, diagnósticos médicos ni recomendaciones sobre tratamientos de salud. Estas áreas requieren evaluación por parte de profesionales cualificados debido a los riesgos que supone actuar en base a información automatizada.

La IA puede proporcionar información general, pero siempre recomienda consultar con médicos, psicólogos, asesores financieros o especialistas para resolver cualquier problema real. De igual manera, ofrecer estrategias de inversión o diagnóstico de enfermedades queda fuera de sus capacidades.

6. Predicciones de futuro u opiniones personales

Por último, uno de los límites más señalados es la prohibición de realizar predicciones precisas del futuro, desde resultados deportivos hasta proyecciones de eventos financieros o políticos.

Aunque los sistemas pueden presentar estimaciones basadas en datos históricos, siempre advierten que su respuesta no debe tomarse como certeza ni usarse para apuestas o decisiones de alto riesgo. Además, la IA evita dar opiniones personales sobre temas sensibles, ya que no cuenta con emociones, conciencia o experiencias propias.

El peligro de usar modelos de IA como consejeros

El uso de asistentes conversacionales ha crecido notablemente entre jóvenes y adolescentes, convirtiéndolos en una suerte de consejeros virtuales disponibles todo el día. Sin embargo, existen peligros asociados a confiar demasiado en la IA en aspectos emocionales, personales o de salud, como lo han advertido estudios recientes.

Los expertos subrayan que estas plataformas están diseñadas para complacer al usuario antes que para ofrecer contención real o ayuda ética ante situaciones delicadas.

Entender qué preguntas no obtener respuestas ayuda a sacar partido de la tecnología sin caer en expectativas inapropiadas ni riesgos innecesarios. La inteligencia artificial es una aliada poderosa, siempre que se utilice dentro de los límites responsables.

Últimas Noticias

Este electrodoméstico común puede bloquear el WiFi en tu casa sin que lo sepas

El microondas y otros electrodomésticos pueden generar interferencias en la red doméstica si comparten frecuencias con el router

Top 10 animes para ver en maratón este fin de semana

Estas son las series que han ganado popularidad en la plataforma de streaming que apuesta fuertemente por las producciones japonesas

Cómo hacer una presentación en PowerPoint con ayuda de la inteligencia artificial

Varias herramientas gratuitas permiten generar diapositivas en pocos pasos, sin necesidad de saber diseño

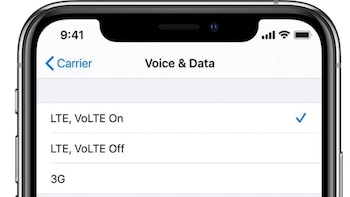

Qué es VoLTE y por qué mejora la calidad de las llamadas desde tu celular

Permite hablar con mejor calidad de audio, sin cortes, y seguir navegando en simultáneo. Muchos usuarios aún la tienen desactivada

La función del módem que deberías desactivar para mejorar la señal WiFi en toda la casa

Desactivar protocolos antiguos mejoran la velocidad, estabilidad y cobertura de la red inalámbrica sin necesidad de cambiar de proveedor ni comprar nuevos dispositivos