La Universidad de Pensilvania ha desarrollado un robot con inteligencia artificial dotado de una visión sobrehumana, capaz de ver a través de paredes, humo y vidrio.

Esta innovación en percepción basada en IA podría mejorar los sistemas multimodales, facilitando el desempeño de los robots en entornos desafiantes, como misiones de búsqueda y rescate o vehículos autónomos.

El sistema, denominado PanoRadar, fue creado por Mingmin Zhao, profesor asistente de Ciencias de la Computación e Información, y su equipo. La tecnología convierte ondas de radio en imágenes tridimensionales detalladas, permitiendo a los robots “ver” más allá de las limitaciones de los sensores convencionales.

PanoRadar emplea algoritmos de inteligencia artificial para procesar señales de radio y superar la baja resolución de los radares tradicionales. Al combinar mediciones desde distintos ángulos, su IA optimiza la imagen hasta alcanzar una resolución comparable a la de sensores avanzados como LiDAR.

Esto permite a los robots desplazarse con precisión en entornos complejos y sortear obstáculos donde los sensores convencionales resultan insuficientes.

Cómo este robot logra a ver a través de las paredes

El sistema desarrollado por la Universidad de Pensilvania permite a un robot ver a través de paredes, humo y vidrio mediante el uso de señales de radiofrecuencia (RF) y algoritmos de inteligencia artificial.

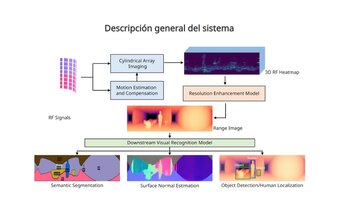

El proceso comienza con la captura de señales RF, que rebotan en los objetos y estructuras del entorno. Estas señales son procesadas por un sistema de imagen de matriz cilíndrica, que genera un mapa de datos en 3D. Para mejorar la precisión, un módulo de estimación y compensación de movimiento ajusta la información recibida, eliminando distorsiones causadas por el desplazamiento del robot.

A partir de estos datos, el sistema genera un mapa de calor 3D de radiofrecuencia, que es refinado por un modelo de mejora de resolución. Este modelo traduce la información en una imagen de profundidad (range image), lo que permite visualizar la posición y forma de los objetos detectados.

La última etapa del proceso involucra un modelo de reconocimiento visual, que analiza la imagen y clasifica los elementos mediante tres técnicas: segmentación semántica (para identificar y diferenciar objetos como paredes, muebles o personas), estimación de superficies normales (para interpretar la orientación y contorno de los objetos) y detección y localización de humanos y objetos.

Para entender su utilidad, imaginemos un equipo de rescate que busca sobrevivientes tras un derrumbe. Un robot equipado con este sistema podría detectar personas atrapadas bajo los escombros sin necesidad de contacto visual, superando las limitaciones de sensores tradicionales como cámaras o LiDAR, que no pueden atravesar materiales sólidos.

Qué otros robots se utilizan en tareas de rescate

Los robots juegan un papel fundamental en las misiones de rescate, permitiendo a los equipos de emergencia operar en entornos de alto riesgo. Uno de los más conocidos es PackBot, desarrollado por iRobot, que fue utilizado tras los atentados del 11 de septiembre en Nueva York. Este robot, equipado con cámaras y sensores, ayudó a explorar los escombros en busca de sobrevivientes.

Otro ejemplo es RoboSimian, diseñado por la NASA, que participó en el Desafío DARPA Robotics, un evento enfocado en desarrollar robots capaces de responder a desastres. Su estructura articulada le permite moverse con estabilidad en terrenos irregulares y manipular objetos con precisión.

En 2011, tras el desastre nuclear de Fukushima, Japón desplegó el robot Quince, diseñado para medir niveles de radiación y explorar áreas inaccesibles para los rescatistas. Su intervención proporcionó información clave para gestionar la emergencia.

Más recientemente, durante los terremotos en Turquía y Siria en 2023, drones y robots equipados con inteligencia artificial fueron utilizados para detectar señales de vida bajo los escombros, optimizando los esfuerzos de rescate.

ultimas

Estos son los tres consejos de Bill Gates para tener un vida feliz y exitosa

El cofundador de Microsoft señala que es importante crear hábitos que fomenten la curiosidad y el aprendizaje

Las seis nuevas habilidades que debes aprender para el futuro, según la Inteligencia Artificial

Es necesario alfabetizarse en IA y manejo de datos debido a que estas tecnologías están transformando todos los sectores de trabajo

Cómo usar Meta AI en WhatsApp para bajar de peso y tener consejos saludables

La inteligencia artificial puede ayudarte a elegir mejores alimentos, planificar tus comidas y establecer rutinas de ejercicio personalizadas desde tu aplicación de mensajería

Los 10 animes más vistos en Crunchyroll para maratonear

Estas son las series que han ganado popularidad en la plataforma de streaming que apuesta fuertemente por las producciones japonesas

Elon Musk dice que en el futuro cada niño tendrá un Einstein como profesor gracias a la IA

El fundador de Tesla y SpaceX afirma que la tarea de inculcar valores y principios morales en los niños será responsabilidad de los padres